夢の超高速計算機「量子コンピュータ」への投資が米国を中心に急拡大している。世界全体での投資額は近年鰻登りで、今年は年間30億ドル(3,000億円以上)を突破しそうな勢いだ(連載第1回参照)。

ニューヨーク証券取引所では、「SPAC(特別買収目的会社)」と呼ばれる特殊な上場テクニックを使って、一度に20億ドル(2,000億円以上)もの巨額資金を調達する量子スタートアップ企業も登場している(図1、2)。

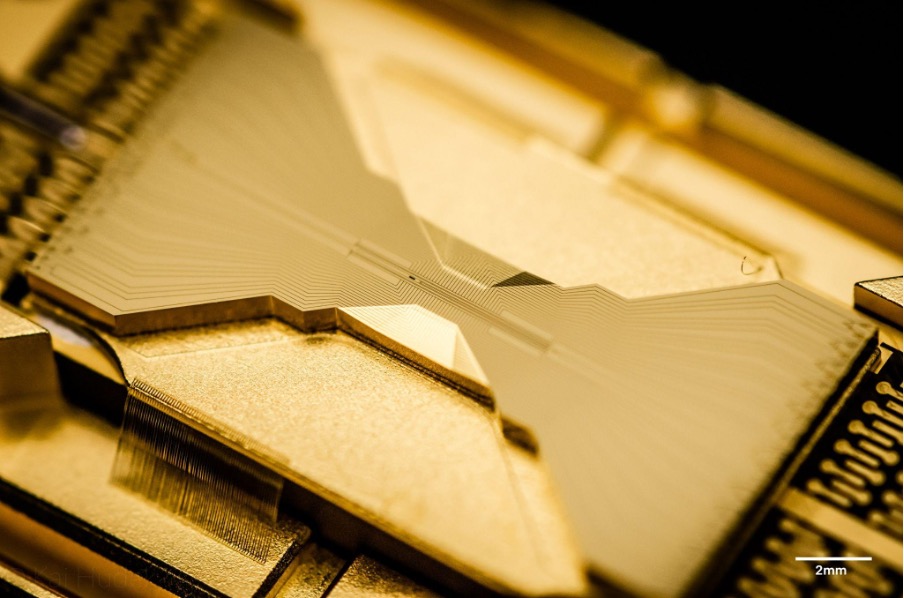

写真提供:IonQ

写真提供:IonQ

難解・深遠な量子力学を理論的な礎とする量子コンピュータの研究開発は、当初から長年に渡って物理学者らが、その実現可能性などを巡って知的な議論を戦わせては楽しむ科学の楽園であった。それが何時の間に、生き馬の目を抜くウォールストリートにおける格好の投資対象へと変貌を遂げたのか?

連載2回目となる本稿からは、量子コンピュータの黎明期から今日のブームへと続く道のりを辿ってみよう。

巨大企業による学究的研究の時代が長く続く

15=3×5 ―― 小学生でも簡単に出来る素因数分解だが、2001年12月に米IBMのアルマーデン研究所が、当時開発したばかりの7量子ビットを処理できる量子コンピュータ(試作機)を使って、この問題を解いたときには周囲から「歴史的なマイルストーン」と高く評価された(量子ビットとは何かについては後述)。

この時の計算で使われたのが「ショアのアルゴリズム(Shor’s factorization)」と呼ばれる素因数分解用の量子計算法だ。しかし、やれることが高々「15の素因数分解」であるとすれば、量子アルゴリズムや、それを走らせる量子コンピュータに一体何の意味があるのか?

その答えは「将来の発展性」である。確かに7量子ビットの段階では、小学生レベルの計算しかできないかもしれない。が、いずれ量子ビットの数を千、万、100万、1億…と増やしていけば、ある段階で量子コンピュータの処理能力は既存のスパコンを遥かに凌ぐと見られた。これが(連載第1回で紹介した)「量子超越性」と呼ばれる現象だ。

しかし量子超越性はあくまで理論的な可能性に過ぎず、それが実現できるという技術的な確証は無かった。このため量子コンピュータの研究開発は、ファインマン博士がその構想を口にした1980年代から長年に渡って、科学者らによる学究的研究の範囲に止まった。また、そうした研究は、資金に余裕のある巨大企業等でしか行えなかった。

前述のIBMアルマーデン研究所における7量子ビット・マシンの開発もその一環と見ることができる。こうした基礎研究によって、少なくとも量子アルゴリズムに従って計算を行う新種のコンピュータが原理的には可能であると示された。が、当時は未だ、実社会の難問を解決する本格的な量子コンピュータを本気で作ろうとする気運は生まれていなかった。

比較的ありふれた材料や技術で量子ビットを作れると判明

潮目が変わったのは2000年代の後半と見られている。

この頃、米国のカリフォルニア大学サンタバーバラ校等の研究チームが、標準的な電子工学の技術や素材を使って量子コンピュータを作れることを実験的に証明した。彼らはシリコンなど半導体の表面に「レニウム」や「ニオブ」など超伝導物質を重ね、それを絶対零度近くまで冷却することで、前述の「量子ビット(qubit)」を生み出すことに成功した。

この量子ビットとは何か?

量子ビットと、それをベースとする量子コンピュータの原理を、従来のコンピュータとの比較で説明すると次のようになる(以下、かなり複雑・難解な説明になって恐縮だが、筋道立てて書いてあるので、時間をかけて辛抱強く読めばご理解頂けるはずだ)。

一般にコンピュータでは、その内部状態を表現する各ビットが0か1かのいずれかを表す。そこではn個のビット列は、0と1の組み合わせ方に応じて全部で(2のn乗)個の状態を表すことができる。

さてパソコンからスパコンに至るまで従来のコンピュータでは、これら(2のn乗)個の状態のうち、ある時点でたった一つの状態しか取り得ない。この一つの状態が時々刻々と次の状態へと推移していく(コンピュータが計算を行うとはそういうことである)。このような方式は「逐次計算(一つ一つ順番に行っていく計算)」と呼ばれる。

もちろん、これら従来型コンピュータも最近では「マルチ・コア、マルチ・プロセッサ」による並列計算をしているが、それはこれから説明する量子コンピュータの並列計算とは性格や次元の異なる話だ。そもそもプロセッサのコア自体を一つのコンピュータと考えれば、それは基本的に逐次演算、つまり「一つの状態が時々刻々と次の状態に推移していく」方式の計算機と見て良いのである。要するに、それが従来のコンピュータである。

これに対し量子コンピュータでは、その内部状態を表現する量子ビットが(ある確率分布に従って)0と1の両方の状態を取り得る。このためn個の量子ビット列は、全部で(2のn乗)個の状態のうち、ある時点で全ての状態、つまり(2のn乗)個の状態をとり得る。そして各々の状態が時々刻々と次の状態へと推移していく。

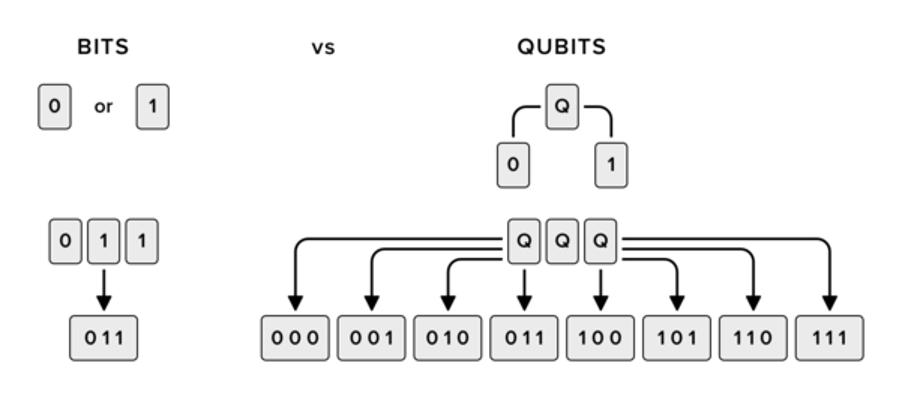

つまり量子コンピュータの内部では、(2のn乗)個の状態を同時並列的に計算できる。これは(2のn乗)個のコンピュータによる並列処理と同じことになる。これが量子並列性と呼ばれる現象だ(図3)。

3ビットを例にとると、従来のビット(左)では同時に1個の状態(2進数)しか取り得ないが、量子ビット(右)では同時に(2の3乗)=8個の状態を取り得る。これが量子並列性

出典:https://serokell.io/blog/modeling-large-quantum-computers

最終的に答えを出力するときには、観測時における「波束(確率分布)の収束」と呼ばれる現象によって、(2のn乗)個の状態がたった一つの状態へと収束する。これが問題の解となる。以上のやり方は、「シュレディンガーの猫」と呼ばれる量子力学のパラドックスを逆手にとったような方法だ。

このように奇妙な性質を帯びた量子ビットを作り出すことは、量子コンピュータを実現する上で最も本質的な条件となっている。

2001年にIBMアルマーデン研究所が7量子ビットの試作機を開発した際には、極めてエキゾティックでお金のかかる特製の化学分子を使って、なんと試験管の中で量子ビットを実現していた。これは誰でも容易に再現できるような代物ではなかった。

これに対しカリフォルニア大学サンタバーバラ校等の研究チームは「シリコンやニオブなど、比較的ありふれた材料や技術」で量子ビットを実現した(もちろんニオブは希少金属だが、資源の一種として多少金を出せば容易に入手できる)。これによって「量子コンピュータを本当に作れそうだ」ということを世界に示したのだ。

これを契機に、欧米ではマイクロソフトやハネウェルなど巨大メーカーが次々と量子コンピュータの研究開発に参入。またIBMも、それまでの細々とした取り組みから、数百人もの物理学者や技術者らを配置した本格的な開発体制へと移行した。

KDDI総合研究所リサーチフェロー 小林 雅一