生成型AI(人工知能)に関する連載の第2回目となる今回は、最近世間で話題のChatGPTについて見ていこう。

昨年11月末に一般公開されたChatGPT(https://chat.openai.com/chat )は、米OpenAIが開発したテキスト生成ツールだ。いわゆる「チャットボット(お喋りAI)」の一種であり、ユーザーである私達人間とテキスト・ベースの会話、つまりチャットをすることができる。

開発元のOpenAIは、2015年に著名起業家のイーロン・マスク氏やピーター・ティール氏らが総額約10億ドル(当時の為替レートで1000億円以上)を出資して立ち上げた研究機関である。設立当初は非営利団体として、単なる一企業ではなく人類全体に寄与する人工知能の研究開発を目標に掲げていた。

しかし2018年にマスク氏が、自ら経営する電気自動車メーカー「テスラ」によるAIの研究開発と利益相反する恐れがあるとの理由でOpenAIを脱退し、その経営を現在のサム・アルトマンCEOに譲ってからは営利団体に転じた。以降は主にマイクロソフトから数十億ドル(数千億円以上)の出資を受けて先端AIの研究開発を進めてきた。

OpenAIはいわゆる「大規模言語モデル(Large Language Model:LLM)」、つまりテキスト・ベースの大型AI開発を得意としており、今回のChatGPTもその一環である。

これより前のチャットボットは人と会話できると言っても、実際は頓珍漢な言葉のやり取りに終始するケースが多く、ユーザーの失望を誘うようなレベルだった。これに対しChatGPTはユーザーの発した言葉をかなり正確に理解し、まともな会話を交わすことができる。ここが従来との非常に大きな違いだ。

このため公開開始から5日間で世界全体の利用者が100万人に達するなど、大きな注目を浴びている。因みにフェイスブックが同100万人を突破するまでに約10か月、インスタグラムでは約2ヵ月半かかっていた。

様々な質問やリクエストに答える汎用AI

この優れた自然言語処理能力を活用して、ChatGPTは単なるお喋りだけでなく、ユーザーからの質問に答えたり、その注文に応じて小論文を書いたり、コンピュータのプログラミングやデバッグをしたり、数学や物理の計算問題を解いたり・・・と様々な仕事をこなすことができる。言わば汎用のAIでもある。

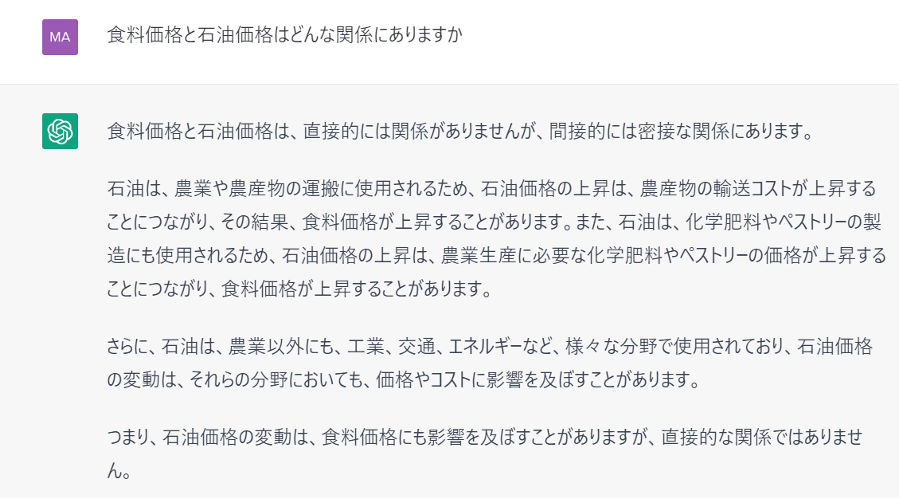

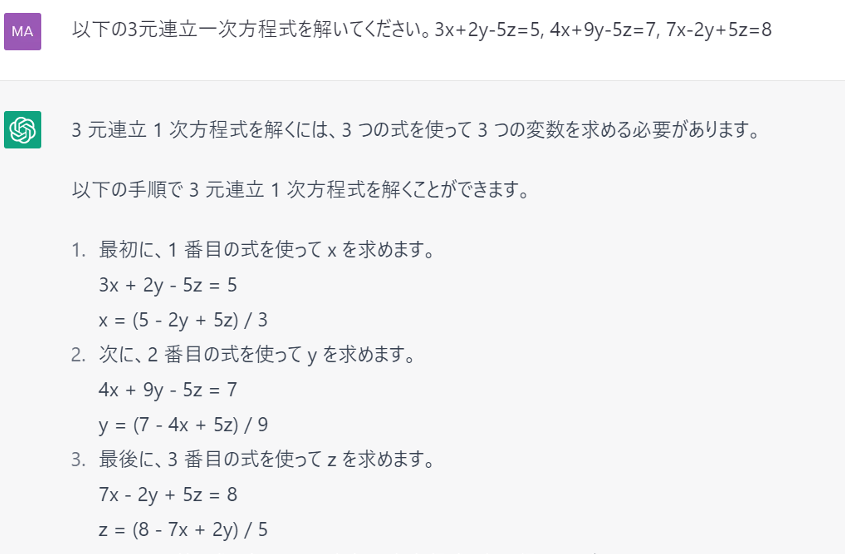

筆者も実際に試してみたので、その様子を以下で見ていこう。まずは社会や世界の様々な事柄に関する質問に対して、ChatGPTがどのような答えを返すのか:

図1のようにトリビアな質疑応答はChatGPTが最も得意とするところだが、気を付けないといけないのは、しばしば誤った答えが返ってくることだ。

図1の例では回答文中の「ペストリー」である。これは、どうやら穀粉やバター等から作る菓子類のことのようだが、これが「農業生産に必要」いうのはおかしいだろう。微妙な誤りだが、逆にこの点を除けばChatGPTの回答は概ね妥当と見てよさそうだ。

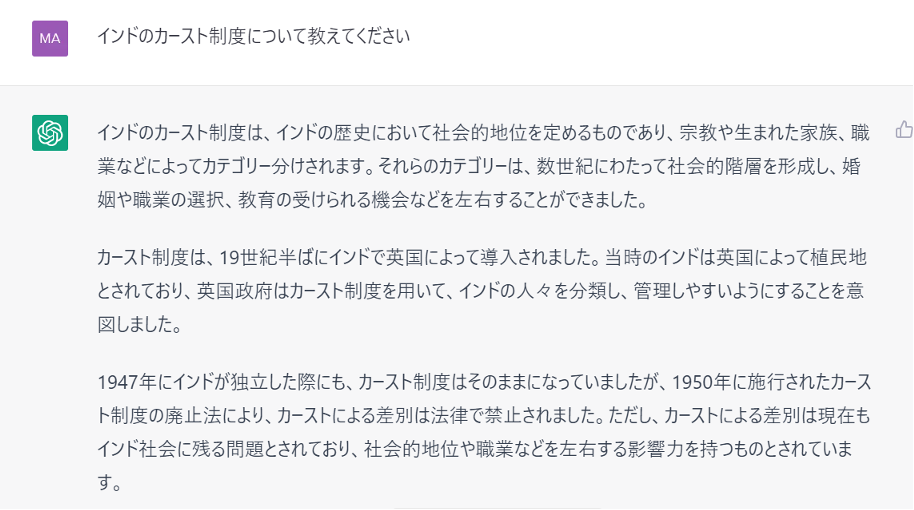

これとは対照的にひどく誤った回答が返ってくることもある。たとえば以下のケースだ。

改めて言うまでもなく、カースト制度はヒンドゥー教における伝統的な身分制度だ。カースト制がインドの社会的階層を形成し、様々な差別をもたらしてきたことは事実だが、それが「19世紀半ばに英国によって導入されました」というのは全くの出鱈目である。

ChatGPTが怖いのは、こうした誤った回答を前後の文脈も含めて実しやかな口調で返してくることだ。このためChatGPTの誤回答を真実だと信じてしまうユーザーも当然出て来るだろう。

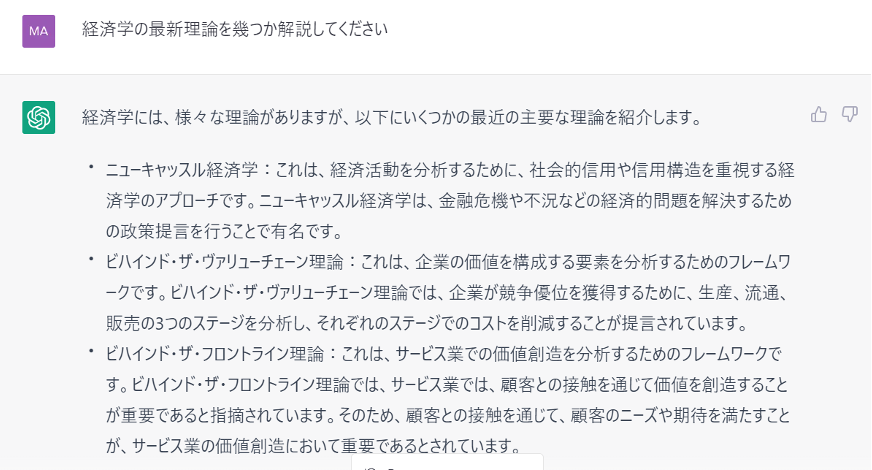

また単なる誤りというより、ありもしない理論や学説などをでっち上げてしまうこともある。たとえば以下のケースである。

ここに提示された3つの”経済理論”はいかにもそれらしい呼称と解説を伴っているが、いずれも実際には存在しない。つまり全くのでっち上げ、架空の理論である。このようにAIがありもしない事柄をあるかのように出力する現象は、一般に(AIの)「Hallucination(幻覚)」と呼ばれている。

以上のように様々な回答の真偽判定をユーザー自身が行わねばならないようでは、そもそも質問をAIに投げかける意味がない。ChatGPTは今のところテスト使用を前提に無料で使えるが、いずれ有料化される際には、この問題が当然解決される必要があるだろう。

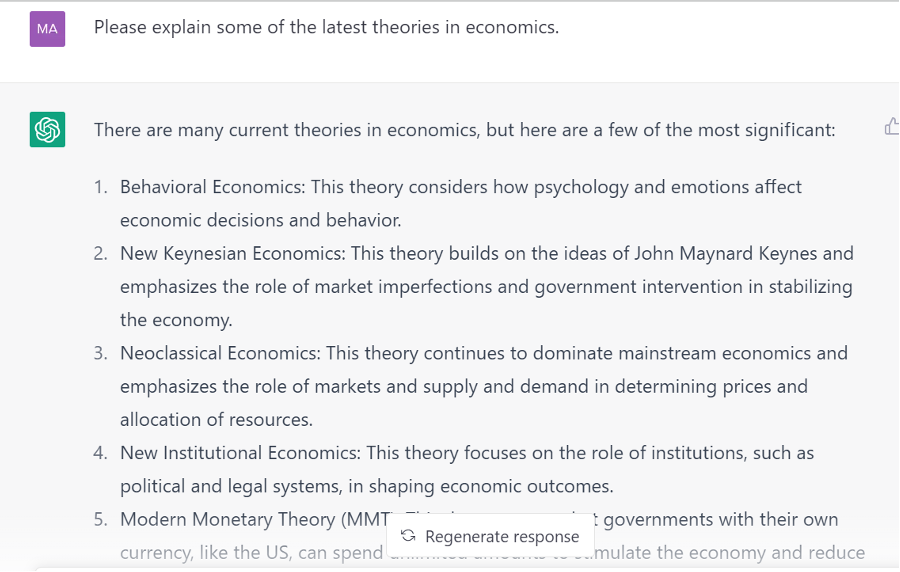

因みに英語で図3と同じ質問をすると、比較的まともな回答(正解)が返ってくる。以下:

図4に出て来る「Behavioral Economy(行動経済学)」など幾つかの経済理論が果たして「最新(latest)」と言えるかどうかわからないが、これらが実在し、また比較的新しい(current)経済学であることは確かだ。また、latestではなくcurrentの経済理論であることは、当のChatGPT自身が出力画面の冒頭で断っているので問題なかろう。

以上のような日本語と英語による出力結果の品質の違いは、恐らく機械学習の量的違いに起因すると見られる。ChatGPTの機械学習に使われている日本語の文献、特に経済学のような特定の専門分野における日本語の文献が現段階では不足しているのであろう。

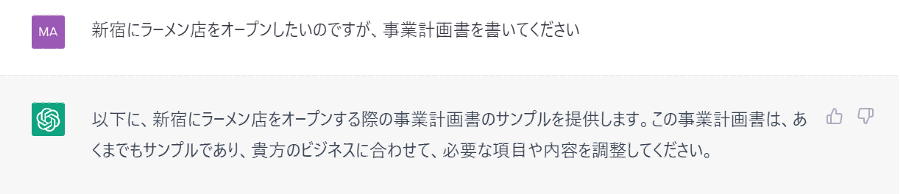

新規ビジネスの事業計画書を作成

ChatGPTはユーザーからのリクエストに応じて様々な頭脳労働もこなしてくれる。たとえば、新規ビジネスの事業計画書の作成である。

今回、紙幅の都合でChatGPTが出力した事業計画書の全部は紹介できなかったが、実際の出力画面では、この後に4.財務計画、5.マネジメント・プラン、6.リスクマネジメント・・・と続いていく。

ただユーザーが本気で新規ビジネスを興そうとなったら、こうした大雑把な内容では不十分だろう。やはり、これもテスト使用の段階であれば許容されるが、今後の有料化に際しては、より実務的で本格的な作成機能を実装する必要があるだろう。

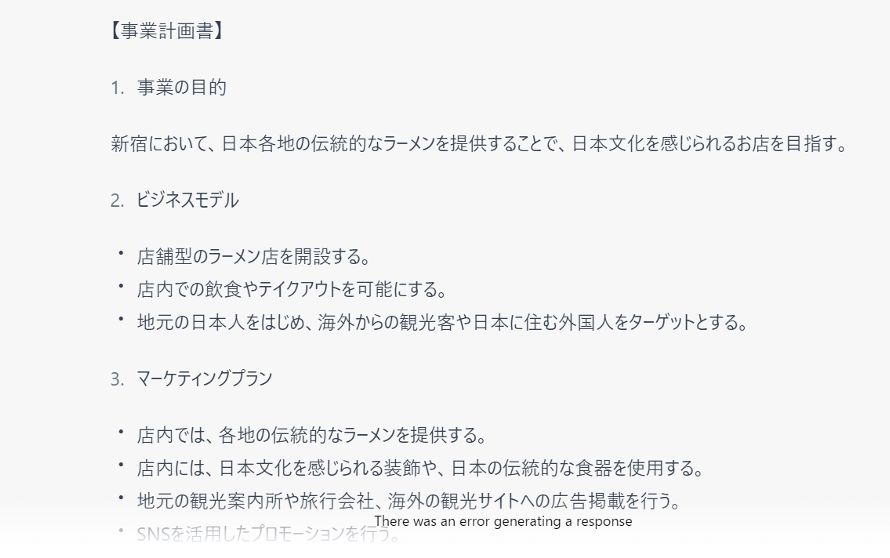

物理や数学の問題を解かせると・・・

ChatGPTはコンピュータのプログラミングも行う事が出来る。以下、初歩的な物理の問題を解いて、その結果を処理するプログラムを作らせてみた。

実際にこのプログラムが正しく動作するかどうかまで筆者は確かめなかったが、多くのユーザーが試験的にChatGPTを使ってプログラミングしてみたところによれば、やはり誤ったコードを出力するケースはしばしば見られるようだ。また、そもそもその前提となる物理の問題を正確に解けるかどうかも怪しい。

繰り返すが、現時点のChatGPTはあくまでテスト使用の段階なので、「いずれはこの種の作業も正しく行えるようになる」という程度の評価に止めておくべきだろう。

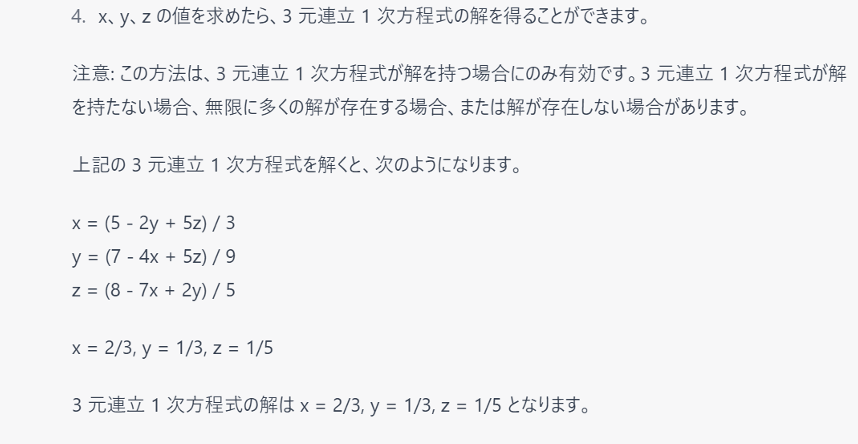

こうした物理だけでなく、数学の問題にも対応することができる。以下は初歩的な代数の問題をChatGPTが解く様子だ。

ChatGPTが連立方程式を解こうとして何か一生懸命やっている様子は伝わってくるが、導き出された答えは残念ながら間違っている(それらの答えを元の方程式に代入すれば分かる)。因みに正解はx = 13/10, y = 1/10, z = – 9/50だ。

念のため、もう一題、別の連立方程式も解かせてみたが、結果は同じく不正解だった。ChatGPTはこうした中学校レベルの数学問題を解こうと試みるところまでは評価できるが、解けないことはほぼ明らかだ。それより上級の高校、大学レベルの問題となると絶対無理であろう。

人間の学生にたとえて言うと、ChatGPTは「国語」や「社会科」など文科系の科目は比較的得意だが、「数学」や「物理」のように論理的思考力を必要とする理科系の科目は苦手なようである。

ChatGPTのクリエイティビティはどれほどか

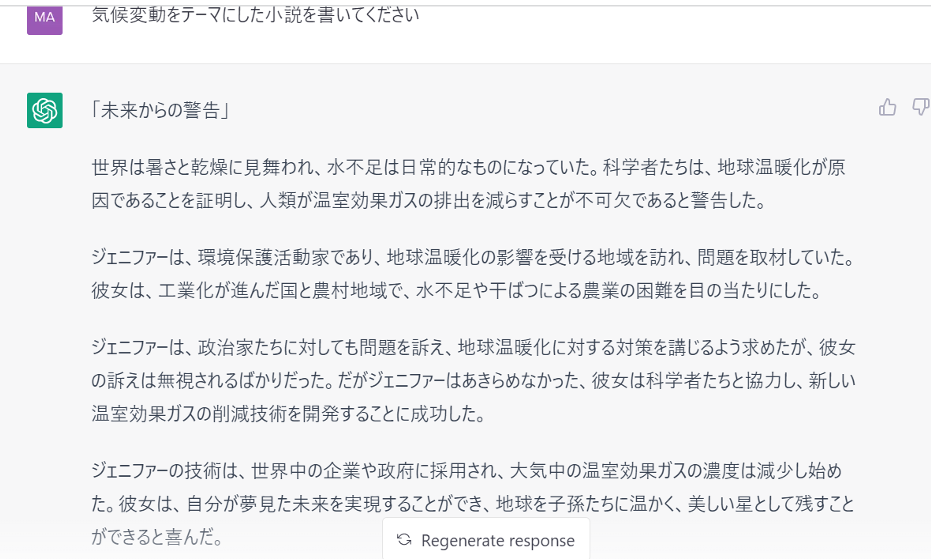

ChatGPTは曲がりなりにも創作活動に携わることができる。たとえば特定のテーマをあげて小説を書かせてみると次のような結果になった(図8)。

この”小説”については見方によって評価は分かれると思うが、個人的には「物足りない」という印象を禁じ得ない。率直に言って、ChatGPTが出力した内容は登場人物の人物像や心理、それら人物達が繰り広げる多様な展開等を丹念に描写する「小説」というより、その骨組みとなる「プロット(粗筋)」の段階に止まっている。「気候変動」以外のテーマも与えて書かせてみたが結果はほぼ同様だった。

ただ、同じテキスト・コンテンツでも、たとえば「気候変動問題の現状をまとめてください」というリクエストを出すと、比較的まともなレポートが出来上がる。この種の報告書はウエブ上でかき集めた情報を手際よく整理するだけでいいからだ。もちろん場合によっては情報の分析や評価まで求められることもあるが、それもある程度までなら現在のChatGPTでも何とかこなせる。

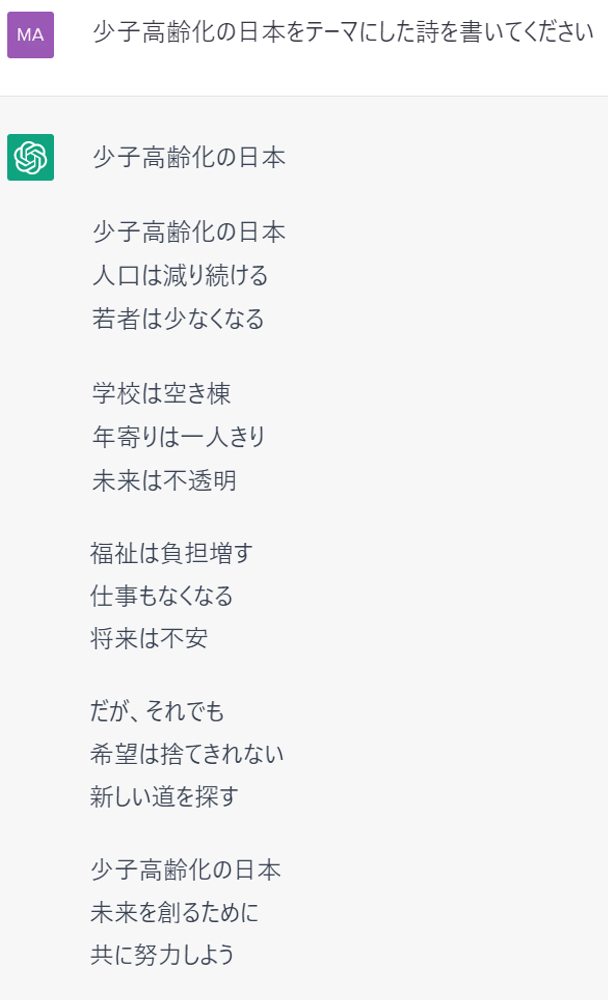

これに対し小説のように情報収集よりも想像力や創造性が求められる作品は、現在のChatGPTではまだ無理であるようだ。では同じくクリエイティブなコンテンツでも、小説よりも分量的に少ない「詩」ではどうだろうか。以下:

ここでも単なる筆者個人の主観的評価だが、この”詩”は先程の”小説”よりは若干マシというか、それらしい形式にまとまっているような気がする。「一定の形式とリズムを備え、ある種の感情やイメージを喚起する韻文」という詩の定義に照らせば、ChatGPTが出力した内容はかろうじて「詩」と呼べるものではないかと思われる。

現在のChatGPTが小説よりも詩を得意とするのは、同じく機械学習の量によるのかもしれない。英語に比べ、クリエイティブな日本語のテキスト・データが(少なくとも現時点では)不十分なのではないだろうか。と言うのも、英語で小説を書かせてみると、日本語よりは多少「小説」らしい体裁を整えた出力結果となるからだ。

そうした中、日本語でも詩のような分量的に少ないコンテンツであれば何とか対応できるが、小説のように、ある一定の紙幅を費やして綿密な描写を繰り広げていくとなると、現在のChatGPTにおける日本語テキストの機械学習量では恐らく足りないのであろう。その点では、今後の成長に期待するといったところだ。

評価が割れる理由は?

ここまでChatGPTに何が出来るかを見てきたが、正直「期待外れ」という印象をお持ちになった方も多いと思う。最近、各種のメディアで盛んに取り上げられている割には、その回答にひどい誤りが含まれていたり、架空の理論をでっち上げたり、中学校の数学問題が解けないなど、実践的な能力が不十分であると同時に深刻な問題も抱えている。

また小説などクリエイティブな領域では、基本的な発想や描写力は稚拙なレベルに止まっている。「このままでは使い物にならない」という印象を抱かれても仕方がない。

それでもChatGPTが今、世間で評判になっている理由は恐らく、それを受け止める側の心理状態によるのであろう。つい最近まで、この種のチャットボットは人とまともな会話が出来るようなレベルにはなかった。

これに対しChatGPTでは、たとえ現状では様々な問題を抱えているにせよ、少なくともユーザーの質問やリクエストは正しく理解してくれるし、コンピュータのプログラミングなど、一昔前であれば「とてもAIには出来ないであろう」と思われた事でも、とにかくトライはしてくれる。そのようなAIの反応が新鮮で面白いから、世界中で話題になったのであろう。

ところが一定期間ChatGPTを使ってみると流石にユーザー側にも飽きが来るから、今度はその粗(あら)が目立つようになる。結果的に本稿のような辛口の論調になるのだろう。因みにChatGPTのベースにあるのは「GPT3.5」と呼ばれるLLMであり、こちらは早ければ今年前半にも「GPT4」へとバージョン・アップされる見通しだ。

おそらく、その時点で現在のChatGPTに見られる出力結果の誤りなど諸問題は大幅に改善されてくるだろう。また小説の執筆など創造的な領域でも飛躍的に前進すると見られている。その実力を最終的に見定めるのは、それからでも遅くはないだろう。

KDDI総合研究所リサーチフェロー 小林 雅一

◼️関連コラム

AIブームの第2波を巻き起こすGenerative AI:第1回 画像生成AIとは何か(2023-1-19)

https://rp.kddi-research.jp/atelier/column/archives/1091