ChatGPTが世界的ブームを巻き起こす中、日本企業の間でも、この画期的ツールを日々の業務に活用して生産性や効率性を上げようとする動きが進んでいる。ブームが盛り上がった今年の春ごろから、テレビや新聞、ウェブなど各種メディアでは頻繁にそれらの様子を報じてきた。

ただ、実際にはメディアで取り上げられるのは少数派で、むしろ日本企業の多くはChatGPTの職場への導入に慎重な姿勢で望んでいるようだ。

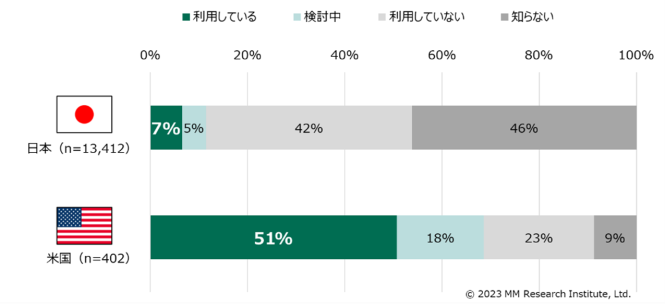

ICT(情報通信技術)分野の市場調査コンサルティングを提供するMM総研(本社:東京都港区)が先月末にウェブ上で実施したアンケート調査によれば、日本の企業・団体に所属する従業員1万3814人のうち、ビジネス(日頃の業務)にChatGPTを利用している人は僅か7パーセント(図1)。

一方「(ChatGPTを)知らない」と回答した人は全体の46パーセント、知っていても「利用していない」との回答は同42パーセントに上る。

これに対し米国ではChatGPTをビジネスに利用する人の割合が全体の51パーセントに達する一方、「知らない」は同9パーセント、「利用しない」は同23パーセントだ。

米国の回答者数は402人と日本よりも大幅に少ないが、恐らく傾向を知る上では十分な数の母集団と見られる。

日米で大きな開きが生じた理由として、MM総研は「経営陣の関心の度合い」を指摘している。

図には示されていないが、米国では経営層の6割以上がChatGPTに強い関心を抱いているのに対し、日本は米国の半分(3割)以下。結果的にChatGPTの有料アカウントなど社内の利用環境において日米で大きな開きが生じたことが、業務における利用率の違いとなって現れているようだ。

一方、会社としてChatGPTの利用に関して何らかの規制を設けている割合は両国とも3割程度と違いはない。

出典:「日米企業におけるChatGPT利用動向調査」、株式会社MM総研、2023年6月12日 https://www.m2ri.jp/release/detAIl.html?id=580

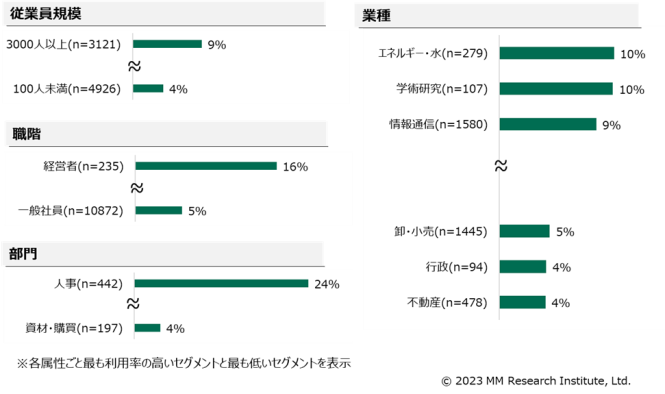

日本企業の中でも、比較的ChatGPTの活用に積極的なのは従業員の多い大手企業だ(図2)。また一般社員よりも、経営陣や管理職の方がChatGPTを利用している事も分かった。

業種的には電力会社などインフラ系、大学など学術研究、情報通信などの業界(領域)でChatGPTはよく使われているが、逆に不動産や地方自治体など行政、卸し・小売り業界などでの利用率は低くなっている。

部門別に見ると、人事部門がChatGPTの活用に積極的であることが分かる。

出典:「日米企業におけるChatGPT利用動向調査」、株式会社MM総研、2023年6月12日 https://www.m2ri.jp/release/detAIl.html?id=580

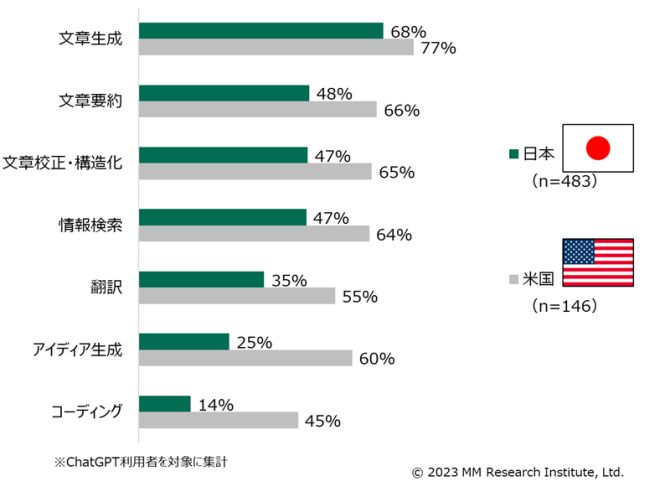

ChatGPTの利用者に具体的な用途を尋ねると、日米とも上位から「文章生成」、「文章校正・構造化」「情報検索」の順となった(図3)。

具体的には「メールなどの定型文を作成する」「議事メモを要約する」「膨大な情報の整理」等を指しており、どんな業種や部門でも必要とされる業務にChatGPTが活用されていることが分かる。

一方、日米で大きな違いが出たのは「アイディア生成」や「コーディング(コンピュータ・プログラミング)」など。米国ではこれらの用途にChatGPTがよく使われているのに対し、日本ではあまり使われていない。

図には出て来ないが、ChatGPTを利用する主な目的は日米とも「既存業務の効率化」であり、「新規事業での活用」や「教育・研修の高度化」などが次なる目標として位置付けられているという。

出典:「日米企業におけるChatGPT利用動向調査」、株式会社MM総研、2023年6月12日 https://www.m2ri.jp/release/detAIl.html?id=580

ChatGPTが生成した内容について満足度を尋ねると、日米とも用途毎に若干の違いはあるものの、10段階評価で概ね6〜7点と評価している。また、9割以上の利用者が「今後も継続して利用したい」と回答するなど、かなり満足していることが伺える。

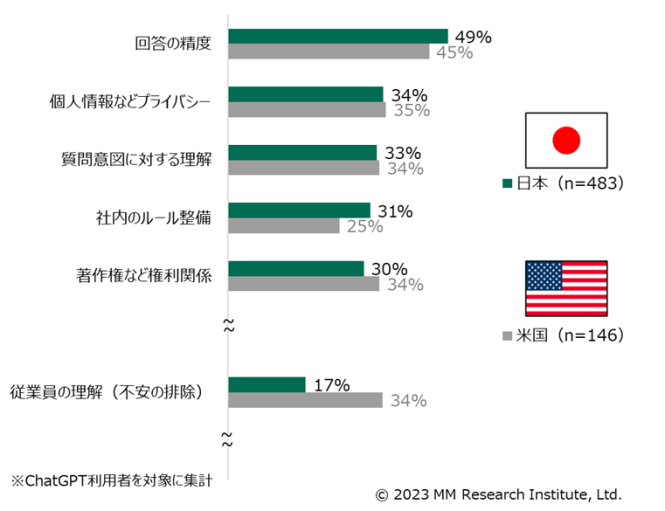

今後ChatGPTの利用を維持・拡大するための課題は、日米とも「回答の精度」が5割弱を占めている(図4)。

また「著作権などの権利関係」にも大きな関心が集まっている。

ChatGPTをはじめ生成AIは、ウェブ上の膨大なデータを機械学習することによって開発された。これらのデータは著作権者に無断で使われているケースが多いため、既にOpenAIなどIT企業と新聞社などコンテンツ・ホルダー間で摩擦が生じ始めている。

今後はこれに関する両者の交渉、さらには司法当局の判断などが生成AIの普及に大きな影響を与えそうだ。

出典:「日米企業におけるChatGPT利用動向調査」、株式会社MM総研、2023年6月12日 https://www.m2ri.jp/release/detAIl.html?id=580

ビジネスパーソンは生成AIとどう向き合うべきか

ここまで見てきたように、ChatGPTのビジネス利用状況については日米の間で大きな開きが生じている。ただ、「日本が米国に遅れをとっているのは問題だ」と決めつけるのは早計かもしれない。

ChatGPTのような生成AIはときに誤った情報や「幻覚」と呼ばれる「でっち上げ」等の回答を返してくる。また、それらの回答(テキストや画像などのコンテンツ)が第三者の著作権を侵害している可能性もある。

これらを考慮するなら、ChatGPTの導入に日本企業の多くが若干及び腰になるのも、ある程度理解できる。

また、一旦導入した後も、その活用に際しては慎重かつ思慮深い姿勢が求められる。

かつてグーグルで「LaMDA」など大規模言語モデルの評価作業を担当していたAI研究者のマーガレット・ミッチェル氏は次のように語っている。

「生成AIは貴方(ビジネスパーソン)が知らないことを知るためのツールではない。むしろ貴方が既に出来ることを、さらによく出来るようにするためのツールなのだ」

これはどういう意味だろうか?

ビジネスパーソンが自分の専門分野で生成AIを使う場合には、これまで培った「専門知識」や「勘」といったものが助けてくれるから、ChatGPTなど生成AIがときに返してくる誤った情報などに騙される可能性は小さい。

逆に、自分の専門以外の言わば「畑違いの分野」ではよく知らない事が多いので、ChatGPTの嘘にコロッと騙される危険性が高まる。ミッチェル氏が指摘しているのは、まさにその点なのだ。

実務歴30年のベテラン弁護士がChatGPTに騙される

ただ、自分の専門あるいは得意とする分野で使うからと言って油断すると酷い目に遭う。

米国では先月、実務歴が30年にも及ぶベテラン弁護士がChatGPTを使って民事裁判の資料を作成したところ、そこに記載されていた数々の判例がいずれも虚偽であることが分かって大問題となった。[1],[2]

事の発端は今から約4年前の2019年8月、ロベルト・メタという男性がエルサルバドルからニューヨークに向かう航空機内で配膳カートがひざに当たって怪我をしたことだ。メタ氏はその時点では何の法的アクションも起こさなかった。しかし最近になって、その怪我を理由に同航空機を運用していた南米コロンビアのアビアンカ航空を訴えた。

これに対しアビアンカ航空の弁護団は「既に、その件は時効だ」との理由でマンハッタン連邦地裁に同訴訟の棄却を求めた。しかし原告(メタ氏)側のスティーブン・シュワルツ弁護士は「時効は成立せず、この裁判は実施されるべきだ」と反論した。

シュワルツ弁護士は、過去に航空会社が被告となった訴訟で、実際に時効が成立しないで裁判が実施されたと主張し、それらの判例が記載された10ページの資料を提出した。そこには「マルチネス対デルタ航空」「ヴァーギーズ対チャイナサザン航空」など、いかにもそれらしい呼称の判例が列挙されていた。

ところがアビアンカ航空の弁護団も判事も、その資料に記された6件の「判例」を法例データベースなどから確認することができなかった。

そこで判事は(資料に記載されたものではなく)本物の判例のコピーを提出するようシュワルツ弁護士に命じた。

これに対して同弁護士は6件の判例全てがChatGPTによって作成された事を明らかにし、それらが実際には存在しない架空の判例であることを認めた。

ここから大騒ぎとなった。

シュワルツ弁護士は宣誓供述書の中で「自分は意図的に法廷や航空会社を騙すつもりはなかった。あくまでリサーチのためにChatGPTを使い、結果的にそれに騙された」とする旨を述べた。

今月6日に、このベテラン弁護士の懲戒処分を決めるための審理が連邦地裁で開かれた。法廷の傍聴席には、報道関係者や弁護士、法律事務官、さらに大学教授や法律専攻の大学生など70名近くが着席して審理を見守った。

その人たちの目の前で、判事はシュワルツ弁護士に「なぜ(ChatGPTの)回答の真偽を確認する作業を怠ったのか?」と問い詰めた。

これに対し同弁護士は「ChatGPTが判例をでっち上げるとは思わなかった」と答えた。

彼は大学に通っている自分の子供達からChatGPTの話を聞いて、その存在を知った。その話から「(ChatGPTとは)スーパー検索エンジンのようなものだ」と思ったという。

実際に同弁護士がChatGPTを使って判例の資料を作成した際には、それが返す答えは自信に満ち溢れているように見えた。

それでも彼は念のためChatGPTに「これらの判例は事実だろうね?」と問い質したところ、ChatGPTは「全て事実です」と答えた。そもそも嘘をつくかもしれないAIに真偽を確かめること自体が大きな過ちだが、今更それを言ったところで後の祭りだ。

この日の審理から判事はシュワルツ弁護士の懲戒処分を決めるが、どの程度の処罰になるかは未だ分からない。それが分かるまで、弁護士は不安に苛まれるだろう。 一方、法科大学院の教授ら専門家の中には「この一件でChatGPTの危険性が知れ渡ったので、今後は一種の抑止効果が期待できるのではないか」と前向きに受け止める人もいる。 日本でもこうしたケースを参考に生成AIへのスタンスを検討しながら、徐々にビジネスに導入していく方が賢明かもしれない。

KDDI総合研究所リサーチフェロー 小林 雅一

◼️関連コラム

第5回 グーグルやBingなどの検索エンジンは対話型AIの導入でどう生まれ変わるか(2023-5-22)

https://rp.kddi-research.jp/atelier/column/archives/4368

第4回 ChatGPTなど生成AIは私達の仕事や雇用をどう変えるか(2023-4-10)

https://rp.kddi-research.jp/atelier/column/archives/1276

◼️参考文献

[1]”Here’s What Happens When Your Lawyer Uses ChatGPT,” Benjamin Weiser, The New York Times, May 27, 2023

[2]The ChatGPT Lawyer ExplAIns Himself,” Benjamin Weiser and Nate Schweber, The New York Times, June 8, 2023